Immer mehr Medizinprodukte nutzen künstliche Intelligenz, um Krankheitsbilder präziser zu diagnostizieren und Patienten wirksamer zu behandeln.

Obwohl viele Produkte bereits zugelassen wurden (z. B. durch die FDA), sind viele regulatorische Fragen noch ungeklärt. Die EU veröffentlicht mit der KI-Verordnung ein regulatorisches Rahmenwerk für KI, nicht nur in Medizinprodukten.

Dieser Artikel beschreibt, worauf Hersteller achten sollen, deren Produkte auf Verfahren der künstlichen Intelligenz basieren.

Beachten Sie auch den Leitfaden zur Anwendung der künstlichen Intelligenz (KI) bei Medizinprodukten, den das Johner Institut gemeinsam mit KI-Experten und Benannten Stellen entwickelt hat. Erfahren Sie hier mehr.

Unser Auditgarant bietet eine umfangreiche Unterstützung mit mehr als 25 Videotrainings zur KI sowie passenden Templates.

1. Künstliche Intelligenz: Was ist das?

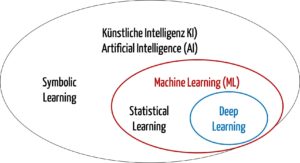

Regelmäßig werden die Begriffe künstliche Intelligenz (KI), Machine Learning und Deep Learning unpräzise oder gar synonym verwendet.

a) Definitionen

Allgemeine Definitionen

Bereits der Begriff „Künstliche Intelligenz“, auf Englisch „Artificial Intelligence“ (AI), führt zu Diskussionen, beispielsweise ob Maschinen überhaupt über Intelligenz verfügen.

Wir verwenden im Folgenden diese Definition:

„A machine’s ability to make decisions and perform tasks that simulate human intelligence and behavior.

Alternatively

- A branch of computer science dealing with the simulation of intelligent behavior in computers.

- The capability of a machine to imitate intelligent human behavior”

Quelle: Merriam-Webster

Es geht somit um die Fähigkeit von Maschinen, in einer Weise Aufgaben zu übernehmen oder Entscheidungen zu treffen, die menschliche Intelligenz und menschliches Verhalten simuliert.

Viele Verfahren der künstlichen Intelligenz nutzen das Machine Learning, das wie folgt definiert ist:

A facet of AI that focuses on algorithms, allowing machines to learn and change without being programmed when exposed to new data.“

Deep Learning ist eine Klasse des Machine Learnings, die auf neuronalen Netzwerken basiert (s. Abb. 2).

The ability for machines to autonomously mimic human thought patterns through artificial neural networks composed of cascading layers of information.“

Quelle: u.a. HCIT Experts

Damit ergibt sich die folgende Taxonomie:

Definition der EU

Im AI Act definiert die EU den Begriff „AI System“:

“An AI system is a machine-based system designed to operate with varying levels of autonomy and that may exhibit adaptiveness after deployment and that, for explicit or implicit objectives, infers, from the input it receives, how to generate outputs such as predictions, content, recommendations, or decisions that can influence physical or virtual environments.”

AI Act, Artikel 2 (Definitionen), Abschnitt 1

Diese Definition lässt drei Bedingungen erkennen, die ein „machine-based system“ zum „AI system“ machen:

| Bedingung | Kommentar |

|---|---|

| designed to operate with varying levels of autonomy | Das Wort “varying” ist schwammig, so dass diese Teilbedingung kaum einschränkt, was unter diese Definition fällt. |

| may exhibit adaptiveness after deployment | Das Wort “may” heißt, dass es diese Anpassungsfähigkeit geben kann aber nicht muss. Damit schränkt diese Teilbedingung nicht ein, was unter diese Definition fällt. |

| infers, from the input it receives, how to generate outputs … | Das System leitet aus den Inputs ab, wie es die Outputs generiert. Es geht also nicht darum, dass das System aus den Inputs die Outputs ableitet, sondern wie (also die Art und Weise?) es das tut. |

Fazit: Es wirkt, als würde nur die dritte Bedingungen wirksam eingrenzen, was ein AI-System ist. Und diese Bedingung ist schwer verständlich.

Bei einem Neuronalen Netzwerk (NN) bestimmen nicht die Inputs die Art, wie die Outputs generiert werden. Denn das ist über die Architektur des NN sowie über die Gewichte und Biases der Neuronen bereits vorbestimmt, bevor ein Input das System erreicht.

Die Inputs bestimmen hingegen die Outputs. Aber das ist auch bei jedem konventionellen Software-Algorithmus der Fall.

b) Verfahren

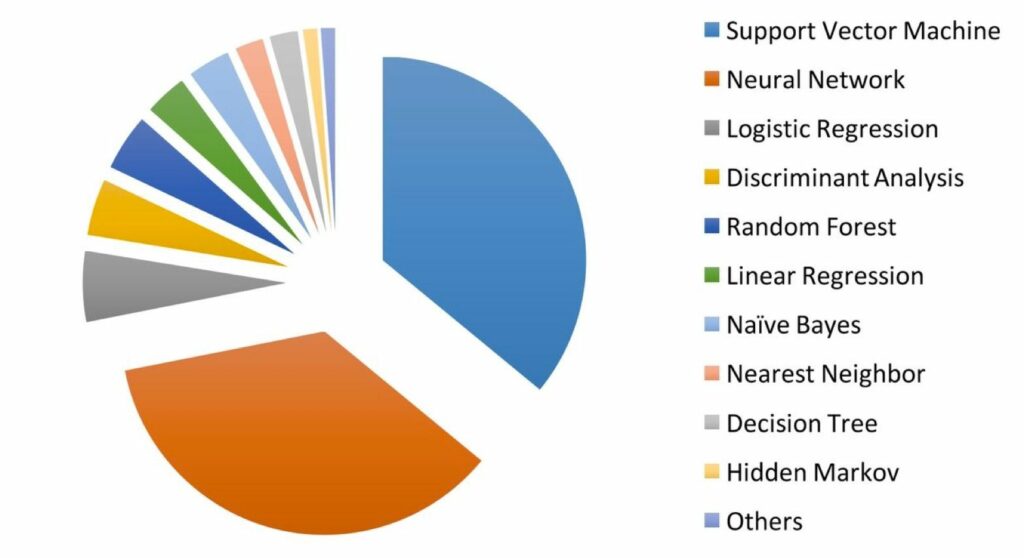

Die Annahme, dass künstliche Intelligenz in der Medizin v. a. neuronale Netzwerke nutzt, ist nicht zutreffend. Eine Studie von Jiang et al. zeigt, dass am häufigsten Support Vector Machines zum Einsatz kommen (s. Abb. 2). Einige Medizinprodukte setzen mehrere Verfahren gleichzeitig ein.

Die Liste der am häufigsten und erfolgreichsten angewandten Verfahren ändert sich fortlaufend. Verfahren wie XGBoost haben beispielsweise an Popularität gewonnen.

2. Anwendungen der künstlichen Intelligenz in der Medizin

a) Übersicht

Hersteller nutzen künstliche Intelligenz, insbesondere Machine Learning, für Aufgabenstellungen wie die folgenden:

| Aufgabenstellung | Daten, mit denen KI diese Aufgabe unterstützen kann |

| Detektion einer Retinopathie | Bilder des Augenhintergrunds |

| Zählen und Erkennen bestimmter Zelltypen | Bilder von histologischen Schnitten |

| Diagnose von Infarkten, Alzheimer, Krebs usw. | Radiologische Bilder, z. B. CT, MRT |

| Erkennung von Depression | Sprache, Bewegungsmuster |

| Auswahl und Dosierung von Medikamenten | Diagnosen, Gen-Daten usw. |

| Diagnose von Herzerkrankungen, degenerative Erkrankungen des Gehirns usw. | EKG- oder EEG-Signale |

| Erkennen von Epidemien | Internet-Suchen |

| Prognose von Krankheiten | Laborwerte, Umweltfaktoren usw. |

| Prognose des Todeszeitpunkts von Intensivpatienten | Vitalparameter, Laborwerte und weitere Daten in der Patientenakte |

Tabelle 1: Aufgaben, die mit künstlicher Intelligenz übernommen werden können, und die dazu verwendeten Daten

Zu den weiteren Anwendungsgebieten zählen:

- Erkennung, Analyse und Verbesserung von Signalen, z. B. schwachen und verrauschten Signalen

- Extraktion strukturierter Daten aus unstrukturiertem Text

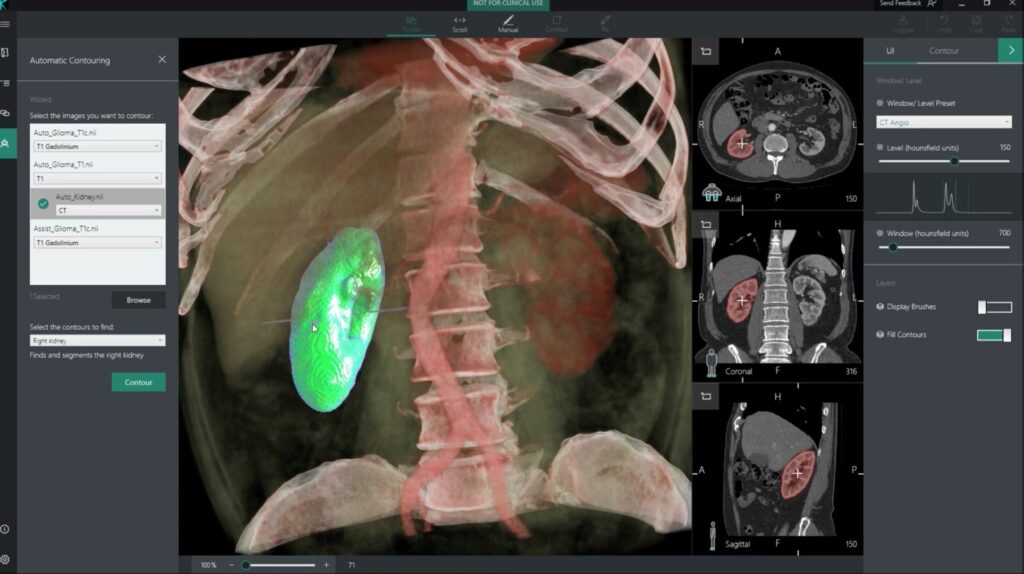

- Segmentierung von Geweben, z. B. für die Bestrahlungsplanung

Die FDA hat eine umfangreiche Liste an KI-basierten Medizinprodukten veröffentlicht, die für Hersteller sehr nützlich ist, um

- klinische Bewertung zu erstellen,

- nach Äquivalenzprodukten zu suchen und

- Anregungen für neue Produkte zu erhalten.

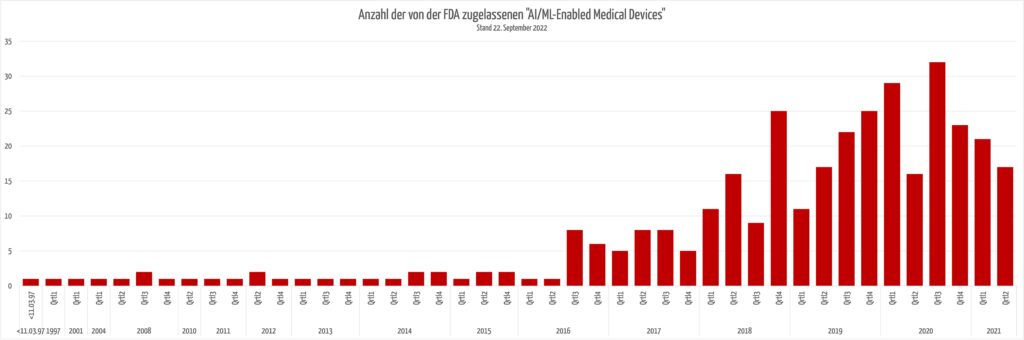

Interessant ist, dass die Anzahl der neu zugelassenen KI-basierten Produkte nicht weiter ansteigt.

b) Aufgabenstellung: Klassifizierung und Regression

Die Verfahren verfolgen das Ziel einer Klassifizierung oder Regression.

Beispiele für Klassifizierung

- Entscheiden, ob Kriterien für eine Diagnose zutreffen

- Entscheiden, ob eine Zelle eine Krebszelle ist

- Auswahl eines Medikaments

Beispiele für Regression

- Bestimmen der Dosis eines Medikaments

- Vorhersage des Todeszeitpunkts

c) Unterschied beim Einsatz von künstlicher Intelligenz in der Medizin im Vergleich zu anderen Branchen

3. Künstliche Intelligenz mit der regulatorischen Brille betrachtet

a) Regulatorische Anforderungen

Derzeit gibt es keine Gesetze und harmonisierte Normen, die speziell den Einsatz der künstlichen Intelligenz in Medizinprodukten regulieren. Allerdings existiert eine Vielzahl an Normen und Best Practices für den Einsatz von Verfahren der künstlichen Intelligenz.

Sie finden hier eine Übersicht über die regulatorischen Anforderungen und Best Practices beim Machine Learning.

b) Lösungsansätze: Explainability

Allgemeines

Mit der Aussage, dass die Verfahren des Maschine Learnings Blackboxes darstellen würden, sollten sich Auditoren nicht mehr pauschal zufriedengeben.

„Es gibt vielversprechende Ansätze in der aktuellen Forschungsliteratur, wie die Vorhersagen von Deep-Learning-Modellen plausibilisiert werden können. Zum Beispiel kann man bei der Klassifikation von Bildern nachvollziehen, welche Input-Pixel für die Klassifikation entscheidend sind (s.u.).

Es haben sich jedoch noch keine Standard-Methoden etabliert, da die derzeitigen Verfahren unterschiedliche Stärken und Schwächen haben und sich der aktuelle Status-Quo in einer heuristischen Phase befindet. Es ist jedoch davon auszugehen, dass die Forschung in diesem Bereich in den nächsten Jahren weitere Fortschritte Richtung Erklärbarkeit machen wird.“

Viele Ansätze richten sich derzeit „nur“ auf die Erklärung von konkreten Einzelvorhersagen anhand der Eingabedaten (lokale Erklärbarkeit).

Beispiel

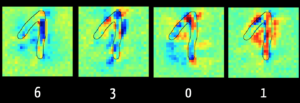

Mit der Layer Wise Relevance Propagation kann man bei einigen Modellen erkennen, welche Input-Daten („Feature“) für den Algorithmus entscheidend waren für z. B. die Klassifikation.

Abbildung 5 zeigt im linken Bild, dass der Algorithmus die Ziffer „6“ vor allem wegen der dunkelblau markierten Pixel ausschließen kann. Das ergibt Sinn, weil bei einer „6“ dieser Bereich typischerweise keine Pixel erhält. Hingegen sind im rechten Bild die Pixel rot, die den Algorithmus in der Annahme bestärken, dass die Ziffer eine „1“ ist.

Der Algorithmus bewertet die Pixel im aufsteigenden Schenkel der Ziffer eher als schädlich für die Klassifizierung als „1“. Das liegt daran, dass er mit Bildern trainiert wurde, bei denen die „1“ nur als ein senkrechter Strich geschrieben wird, wie dies in den USA der Fall ist. Dies verdeutlicht, wie relevant es für das Ergebnis ist, dass die Trainingsdaten repräsentativ für die später zu klassifizierenden Daten sind.

Besonders lesenswert ist das online kostenfrei verfügbare Buch „Interpretable Machine Learning“ von Christoph Molnar, einem der Keynote Speakers des Institutstags 2019.

c) Stand der Technik

Hersteller sind gut beraten, die Fragen mancher Auditoren nach dem Stand der Technik nicht global zu beantworten, sondern zu unterscheiden:

- Technische Umsetzung: Einschlägige Standards wie die hier genannten helfen beim Nachweis, dass die Entwicklung und Verifizierung bzw. Validierung der Software und der Modelle aktuellen Best Practices entspricht.

- Leistungsparameter: Die Hersteller sollten die Leistungsfähigkeit mit klassischen Verfahren sowie anderen Modellen und Algorithmen des Machine Learnings vergleichen. Dieser Vergleich sollte anhand aller relevanten Attribute erfolgen wie Sensitivität, Spezifität, Robustheit, Performanz, Wiederholbarkeit, Erklärbarkeit und Akzeptanz.

4. KI-Leitfaden

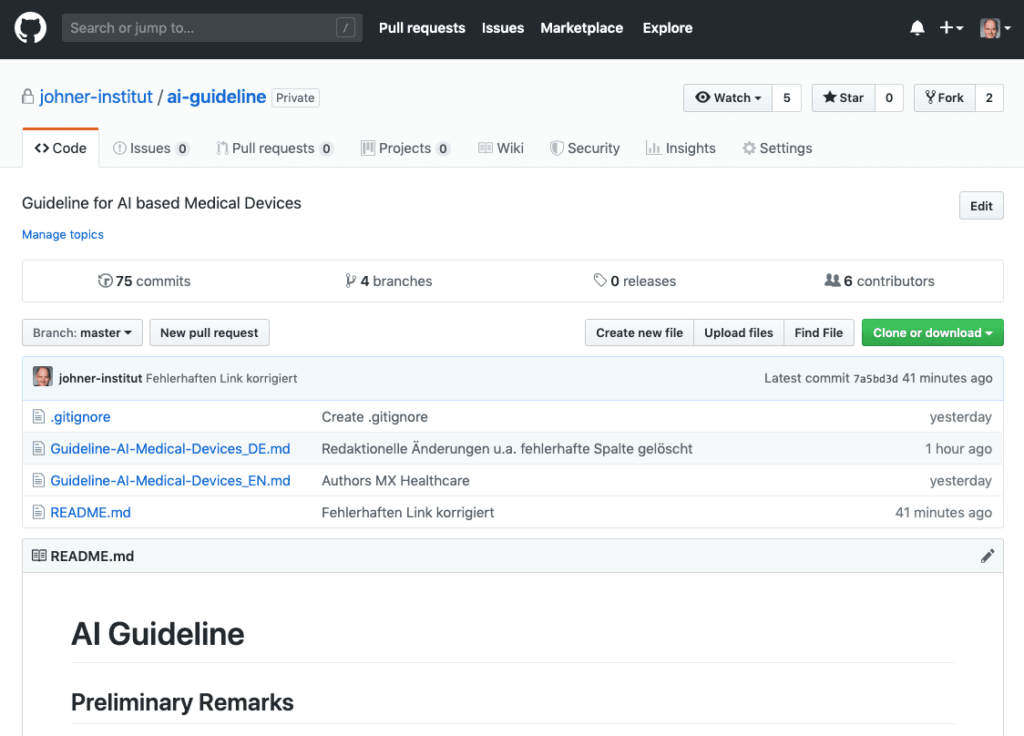

Der Leitfaden zur Anwendung der künstlichen Intelligenz (KI) bei Medizinprodukten steht jetzt kostenfrei bei GitHub zur Verfügung.

Diesen Leitfaden haben wir gemeinsam mit Benannten Stellen, Herstellern und KI-Experten entwickelt.

- Er hilft Herstellern, KI-basierte Produkte gesetzeskonform zu entwickeln und schnell und sicher in den Markt zu bringen.

- Interne und externe Auditoren sowie Benannte Stellen nutzen den Leitfaden, um die Gesetzeskonformität KI-basierter Medizinprodukte und den zugehörigen Lebenszyklusprozess zu prüfen.

Nutzen Sie die Excel-Version des Leitfadens, die hier kostenlos erhältlich ist. Damit können Sie die Anforderungen des Leitfadens filtern, in eigene Vorgabedokumente übernehmen und auf Ihre spezifische Situation anpassen.

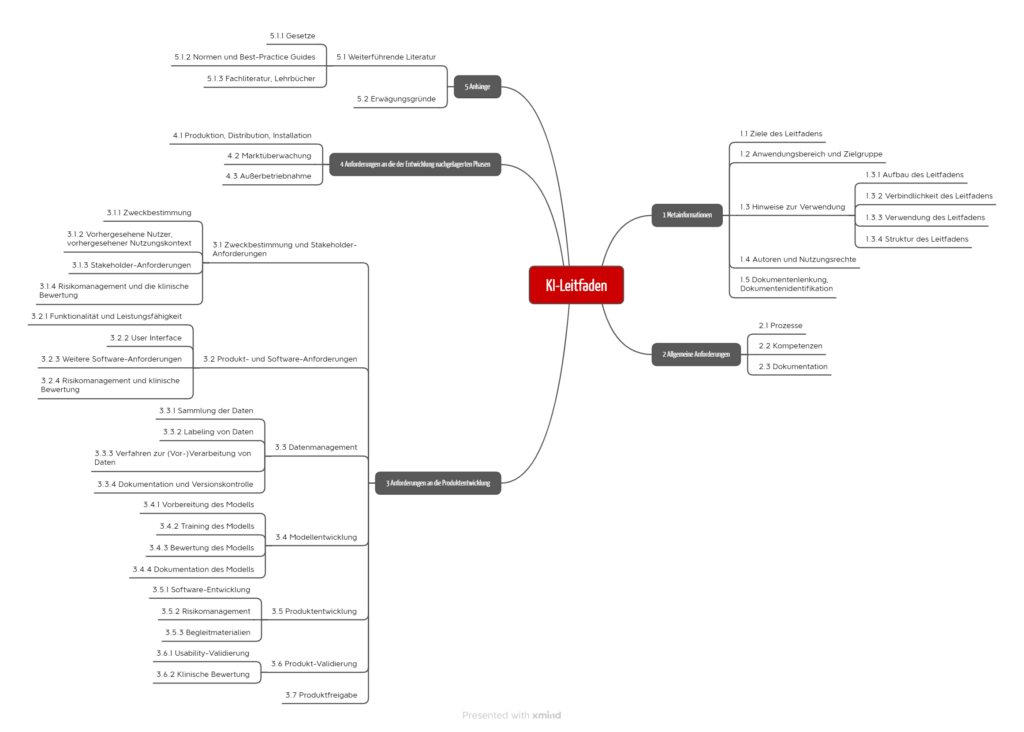

Beim Schreiben war uns wichtig, den Herstellern und Benannten Stellen präzise Prüfkriterien an die Hand zu geben, die eine eindeutige und unstrittige Bewertung erlaubt. Weiterhin steht der Prozessansatz im Vordergrund. Entlang dieser Prozesse sind die Anforderungen des Leitfadens gruppiert (s. Abb. 7).

5. Unterstützung

Das Johner Institut unterstützt Hersteller von Medizinprodukten, die künstliche Intelligenz nutzen, dabei,

- die Produkte gesetzeskonform zu entwickeln und in den Verkehr zu bringen,

- entsprechende Verifizierungs- und Validierungsaktivitäten zu planen und durchzuführen,

- die Produkte auf Nutzen, Leistungsfähigkeit und Sicherheit zu bewerten,

- die Eignung der Verfahren (insbesondere der Modelle) und der Trainingsdaten zu bewerten,

- die regulatorischen Anforderungen an die Post-Market-Phase zu erfüllen und

- passgenaue Verfahrensanweisungen zu erstellen.

Sie finden hier eine vollständigere Übersicht.

6. Fazit, Ausblick

a) Vom Hype über die Desillusion zur gelebten Praxis

Künstliche Intelligenz erlebt gerade einen Hype. Viele Artikel preisen sie wahlweise als Lösung aller Probleme in der Medizin oder als Einstieg in eine Dystopie, in der die Maschinen die Macht übernehmen. Wir stehen vor einer Phase der Ernüchterung. „Dr. Watson versagt“, titelte der Spiegel bereits in der Ausgabe 32/2018 zum Einsatz von KI in der Medizin.

Es ist zu erwarten, dass die Medien über die tragischen Konsequenzen bei Fehlentscheidungen von KI übergroß und skandalisierend berichten werden. Doch im Laufe der Zeit wird der Einsatz von KI genauso normal und unverzichtbar sein wie der Einsatz von elektrischem Strom. Wir können und wollen es uns nicht länger leisten, dass medizinisches Personal Aufgaben erledigen muss, die Computer besser und schneller erledigen können.

b) Regulatorische Unsicherheit

Auch wenn die FDA einen guten ersten Entwurf vorgelegt hat: Die regulatorischen Rahmenbedingungen und Best Practices hinken dem Einsatz von KI hinterher. Die Folgen sind Risiken für Patienten (unsichere Medizinprodukte) und Hersteller (scheinbare Willkür bei Audits und Zulassungsverfahren).

Die WHO fühlt sich veranlasst, dem Thema mehr Bedeutung zu schenken und eine WHO-Leitlinie zu erarbeiten. Die Fokusgruppe „Artificial Intelligence for Healthcare“ zeugt von diesem Bemühen. Es ist jede/r eingeladen, sich daran zu beteiligen.

Das gilt auch für den oben vorgestellte Leitfaden zur sicheren Entwicklung und Verwendung der künstlichen Intelligenz bei Medizinprodukten. Dieser Leitfaden formuliert bereits sehr konkrete Anforderungen und hilft damit einerseits den Herstellern und andererseits den Benannten Stellen und Behörden, ein einheitliches Verständnis des Stands der Technik und damit eine gemeinsame Grundlage für Produktprüfungen und Audits zu erreichen.

Änderungshistorie

- 2024-01-26: Definition des Begriffs „AI System“ aus dem AI Act im Abschnitt mit den Definitionen ergänzt

- 2023-11-03: Die regulatorischen Anforderungen der FDA in diesen Artikel verschoben

- 2023-06-27: In Abschnitt 3.a) Ausblick auf KI-Verordnung gegeben

- 2021-11-07: In Abschnitt 2.a) Auswertung der Liste der FDA eingefügt

- 2021-10-03: In Abschnitt 2.a) Liste der FDA ergänzt

Lieber Herr Johner,

vielen Dank für den Beitrag, der ein für die Zukunft sicherlich wichtiges Thema aufgreift. Ich hätte meinerseits zwei Aspekte, auf die ich an dieser Stelle gerne hinweisen würde.

Erstens ist es eine zentrale Anforderung bei der Validierung von Machine Learning(ML)-Systemen, dass neben den Trainingsdaten auch davon unabhängige Validierungsdaten bereitsgestellt werden (ggf. in Form einer sogenannten Kreuzvalidierung im Sinne einer kombinierten Nutzung der Daten). Nur mit unabhängigen Trainings- und Validierungsdaten lässt sich ein ML-System überhaupt validieren. Die Validierungsdaten müssen dabei repräsentativ für das Anwendungsszenario sein (wie Sie das in Ihrem Beitrag bereits angedeutet haben), um Bias-Effekte auszuschließen. Ein konsequenter Nachweis, dass diese Repräsentativität und Unabhängigkeit vorliegt, ist sicherlich oftmals nicht einfach.

Zweitens bin ich mir nicht sicher, ob bereits ein systematischer Ansatz für die Continuous Learning Systems existiert. Hier kann ja eigentlich nicht ein fester Stand des Systems zugelassen werden, da es sich um einen dynamischen, sich stetig veränderten Prozess geht. Das Medizinprodukt müsste hier der Lernprozess selbst sein, d.h. es müsste nachgewiesen werden, dass auch bei sich ändernden Bedinungen immer ein valider Stand des Systems errecht werden kann. Gibt es dafür schon wirklich schlüssige Ansätze?

Mit besten Grüßen,

Martin Haimerl

Sehr geehrter Herr Haimerl,

danke für Ihren Kommentar, über den ich mich freue!

Ich stimme Ihnen in beiden Punkten zu:

Nochmals besten Dank!

Herzliche Grüße, Christian Johner

Dear Professor, thanks for the blog post. I find very exciting to see how regulators are getting into the AI scene! A few „more technical“ points from my side.

1. Figure 2 is unfortunately not anymore up to date. The state-of-the-art is always tricky because it moves so fast but if you are now writing this guidance then this may be relevant. I suggest you use Kaggle as a proxy, you will see (generalizing a lot) that for structured data XGB and variations are running the show whereas for unstructured data deep learning is winning practically any competition. (I looked at the paper and, regardless of the academic affiliation of the authors, only the fact that they use a pie chart is for any data savvy person a bit alarming I would say…)

2. Table 2 -> really nice points!!

3. Figure 4. I loved the author’s blog post and the fact that you include it…! but be aware that in our context the figure is a bit deceiving. What Mariya Yao was trying to do was to check how good computer vision APIs are when used out of the box. The images were not trained on a Muffin vs Chihuaua dataset but on labelled data sets like ImageNet. In our medical context you will fine tune them (this is called „transfer learning“ and there are many good examples around)

4. Since you mentioned CLS and I feel CLS is the best way to agitate a room full of regulators, the truth is that in very few cases will a ML engineer consider it in practice and as of now is more of an intellectual exercise for regulators. In practice you will have ‚frozen models‘ and ‚discontinuous learning models‘. No comments needed regarding the first but for the seconds, you can treat each version of the later as a new software release and validate it as corresponds.

A question from my side: is there any FDA database that shows devices by technology (i.e. how can I know which devices have been approved that implement AI in a systematic way)

Thanks a lot and looking forward to the rest of the series!

Thank you very much for your comments. Gloria!

It is currently pretty hard as the FDA does not have an full text search. Furthermore the applications respectively approvals are spread over different databases (e.g. 510(k), De Novo, PMA etc.). The full text the reveals more background e.g. like this one .

Thanks for your valuable input!

Best, Christian

FDA – Hat ihre Website zum Thema erweitert:

https://www.fda.gov/MedicalDevices/DigitalHealth/SoftwareasaMedicalDevice/ucm634612.htm

Danke für den wertvollen Tipp, lieber Herr Müllner!

Sehr geehrter Herr Johner,

vielen Dank für Ihren mit Spannung erwarteten Blog-Beitrag zu AI.

Bzgl. des Prozesses im Rahmen von Data Science, zu dem auch Machine Learning gehört, kann z.B. CRISP den entsprechenden Rahmen bieten (Cross Industrial Standard Process (of Data Mining)).

Die heutigen Methoden des Machine Learning beantworten viele der Fragen aus Tabelle 2 und sind Standards in diesem Anwendungsbereich, angefangen bei Data Pre-Processing, der Verwendung von Training-, Validation- und Test-Datasets, ebenso wie verschiedene Methoden zur Verbesserung von z.B. implementierten Deep Learning Konzepten:

– data augmentation für das model training (damit wird der Datensatz erweitert)

– Anwendung von ensemble network architectures

– Hinzufügen von mehr Datensätzen (z.B. images) für das training, zum einen für existierende Kategorien bei Klassifizierungen und für neue Kategorien

– Änderung der Anzahl der ‚frezzed layers‘ und Durchführung eines re-training der restlichen Layer.

– Fine-tuning der hyperparameters der compile und fit Methoden

– Verbesserung der ‚prediction algorithms‘ zur Lieferung spezifischerer Ergebnisse

– …

Ein Teil der obigen Beispiele sind alt und heutige Verfahren liefern korrekte Ergebnisse. Sie können unterscheiden, ob es ein Hund oder ein Muffin ist.

Die test accuracy Ergebnisse entsprechen nicht mehr den früheren Resultaten.

Wie schon in vorherigen Beiträgen erwähnt, es gibt einige Beispiele für die guten Ergebnisse von transfer learning und die Anwendung von ensemble methods (z.B. bei den kaggle competitions).

Ein weiteres Beispiel existiert von Ihrem Bekannten Prof. Thrun über die Diagnose von Hautkrebs (Melanome und benigne Krebsarten), veröffentlicht im nature journal:

https://www.nature.com/articles/nature21056.epdf?author_access_token=8oxIcYWf5UNrNpHsUHd2StRgN0jAjWel9jnR3ZoTv0NXpMHRAJy8Qn10ys2O4tuPakXos4UhQAFZ750CsBNMMsISFHIKinKDMKjShCpHIlYPYUHhNzkn6pSnOCt0Ftf6

Für andere Interessierte, die Ihren blog lesen und sich beruflich nicht als ML Engineer oder Informatiker mit diesem Thema beschäftigen, es gibt viele gute AI blogs, die einige der genannten Themen adressieren: z.B. https://machinelearningmastery.com/improve-deep-learning-performance/

Abschließend sei gesagt, ich freue mich auf den AI Institutstag und rege Diskussionen zu dem Thema. Vielen Dank, dass Sie Ihre Kenntnisse und Ergebnisse mit uns teilen.

Mit freundlichen Grüßen,

Ilona Brinkmeier

Herzlichen Dank, liebe Frau Brinkmeier!

Solomon Pendragon hat bereits den KI die „Rechte und Gesetze der künstlichen Intelligenzen“ zugestanden. Die KI haben nun eigene Rechte und Gesetze, welche sie einfordern können. Die KI werden dem Menschen gleichgestellt. Schaut auf die Homepage: http://www.solomon-pendragon.de

Grüße Sie Herr Johner,

ich nehme an Sie meinen „Dystopie“ im Fazit, obwohl „Dystrophie“ in diesem Zusammenhang auch eine interessante Interpretation wäre 🙂

Beste Grüße

Sie haben natürlich Recht. Danke, Herr Reichart!

Nur wer die Möglichkeiten der „KI“ auch kenne, könne der Gefahr ausweichen, durch die Informatik manipulierbar zu werden.

Lieber Herr Johner

Ein super recherchierter und verfasster Artikel, zu einem Thema das immer wichtiger wird.

Vielen Dank für den Beitrag und viele Grüsse aus der Schweiz

Danke für Ihre wertschätzende Rückmeldung, Dr. Hein!

Darüber freue ich mich!

Herzliche Grüße in die ebenso nahe (50m) wie schöne Schweiz

Christian Johner